[思考]-李沐讲座:大语言模型的实践经验和未来预测

硬件

- 带宽的重要性高,机房、机架、芯片的密集程度、摆放的位置会产生延迟,延迟会对计算速度产生很大的影响。

- 内存的大小目前受到工艺和技术的限制,未来比较长的一段时间可能会在200GB以内,也就是说其实模型大小在未来一段时间中会被控制在一定的范围内,而不是由于算力的限制导致模型大小无法扩展。

- 算力

- 供电,李沐老师提到曾经花几个月去调研发现,自己造一个电厂的成本比用电还低。

- 硬件的价格,长期来看算力会越来越便宜,在自由竞争的市场中,算力翻倍的情况下,算力的价格应该维持不变。

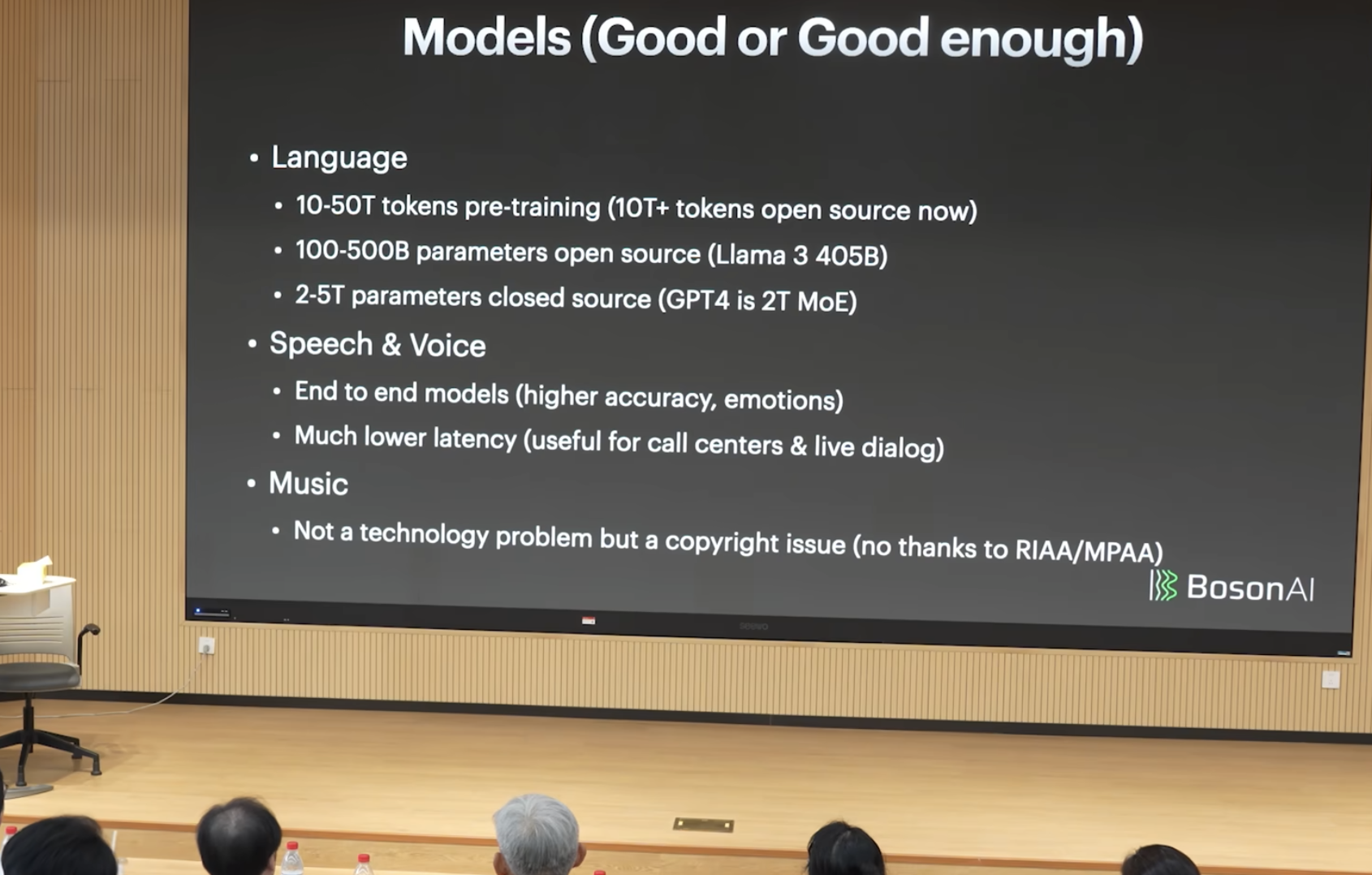

模型

Token的数量级不会有显著提升

模型大小在100-500B

音乐的生成

语言交互的延迟降低了

图片逐渐的有”灵魂”,缺少了一下情绪的表达

视频的生成,视频的数据处理的成本很可能高于视频生成模型生成的一个成本

多模态能借用文本模型的泛化能力去支持其他模态,自然语言交互可能是未来的一个常态。能用清晰,有条理的语言去组织和表达自己想做的事情是一个很重要的能力。

Killer app概念,短视频是最近的一个Killer app

简单任务 复杂任务 文科白领 ✅ 🏗️ 理科白领 🏗️ Moonshot 蓝领 Moonshot Moonshot 目前的进展来看,很难解决蓝领的问题,而蓝领是这个世界上最主要的成员

算法

- 预训练是一个工程问题

- 后训练中,高质量的数据和算法很重要

- 垂直模型可能是个伪命题,没有一个真正的垂直模型,垂直模型的通用能力也是很强的。

- 模型的评估是重要的一个部分,自然语言有一定的二义性,模型评估会带来bias问题。

- 算法决定模型下限,数据决定模型上限。

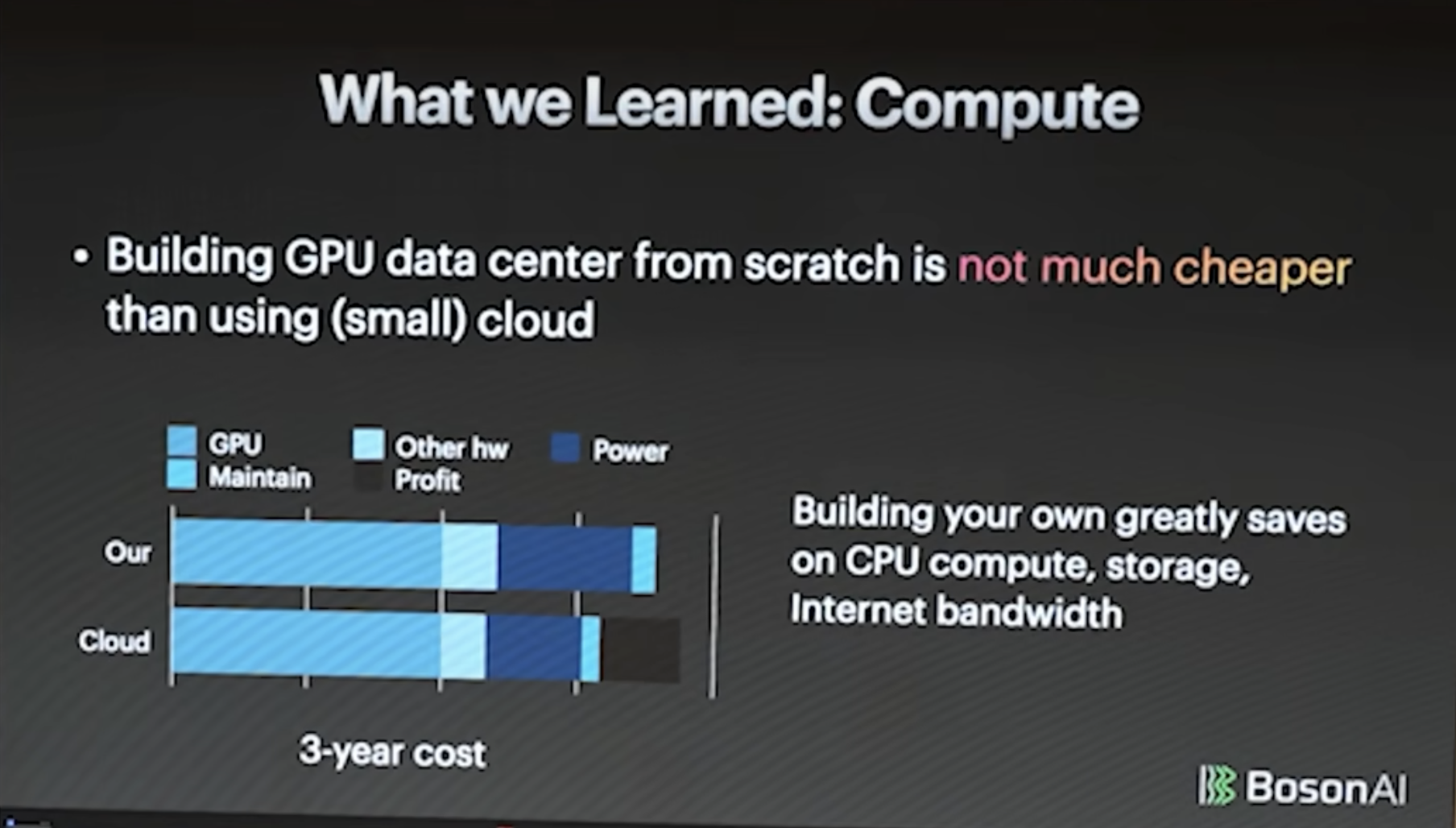

- 自建服务器的价格其实和使用云服务器差不多

[思考]-李沐讲座:大语言模型的实践经验和未来预测

https://dinghanyang.github.io/dhy_blog/2024/08/30/LLM-speech-from-Mu-Li/